DeepMind набирает специалистов для защиты от сильного ИИ

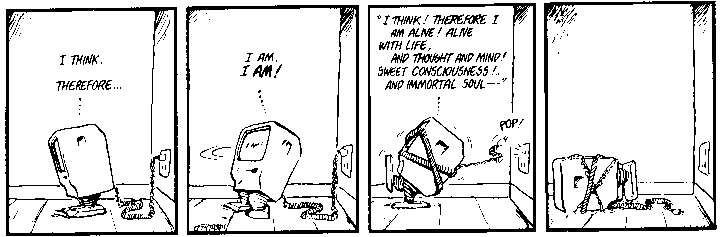

Лондонская научно-исследовательская компания DeepMind (собственность Google) специализируется на передовых разработках Искусственного интеллекта, который в перспективе может развиться в форму сильного[1] Искусственного интеллекта. Согласно теории, сильный ИИ, возможно, будет способен мыслить и осознавать себя, сопереживать (чувствовать). При этом он будет обладать следующими свойствами.

- Принятие решений, использование стратегий, решение головоломок и действия в условиях неопределенности.

- Представление знаний, включая общее представление о реальности.

- Планирование.

- Обучение.

- Общение на естественном языке.

- Объединение этих способностей для достижения общих целей.

Очевидно, что программа с такой функциональностью может действовать непредсказуемо для разработчиков. Собственно, она специально будет запрограммирована на автономную работу. Поэтому очень важно заранее предусмотреть необходимые меры безопасности.

Из различных источников, в том числе из профилей в социальной сети профессионалов LinkedIn стало известно, что компания DeepMind приступила к набору сотрудников для отдела безопасности ИИ. Это подразделение должно уменьшить вероятность, что сильный ИИ сможет развиться в форму, опасную для человечества и/или для самого себя.

DeepMind — одна из многих компаний в мире, которые работают над созданием самообучаемых нейросетей в форме слабого Искусственного интеллекта. Пока что эти программы ограничены узкоспециализированными задачами: они играют в сложные настольные игры (го) и помогают снизить расходы Google на эклектричество. Но амбиции английских учёных на этом не останавливаются. В перспективе они стремятся разработать универсальную систему ИИ. Как сказано на сайте, компания хочет «решить задачу интеллекта» (solve intelligence), чтобы «сделать мир лучшим местом». Это вполне согласуется базовым принципом корпорации Google — «Don’t be evil».

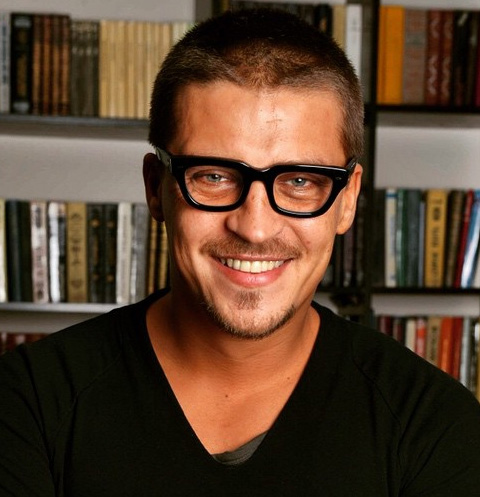

Чтобы снизить шансы развития опасной формы сильного ИИ, компания создала отдел безопасности AI Safety Group (дата формирования отдела и численность персонала не известны). Среди новых сотрудников — Виктория Краковна[3] (Viktoriya Krakovna), Ян Лейке[4] (Jan Leike), Педро Ортега[5] (Pedro Ortega). Например, Виктория Краковна (на фото) принята на должность научного сотрудника, у неё кандидатская степень (PhD) Гарвардского университета по статистике. Призёр международных школьных[6] и континентальных студенческих[7] олимпиад по математике канадско-украинского происхождения была стажёром-разработчиком в Google в 2013 и 2015 годах, а позже выступила сооснователем Future of Life Institute[8] в Бостоне — одной из ведущих научно-исследовательских организаций в мире, которая занимается вопросами безопасности искусственного разума.

Чтобы снизить шансы развития опасной формы сильного ИИ, компания создала отдел безопасности AI Safety Group (дата формирования отдела и численность персонала не известны). Среди новых сотрудников — Виктория Краковна[3] (Viktoriya Krakovna), Ян Лейке[4] (Jan Leike), Педро Ортега[5] (Pedro Ortega). Например, Виктория Краковна (на фото) принята на должность научного сотрудника, у неё кандидатская степень (PhD) Гарвардского университета по статистике. Призёр международных школьных[6] и континентальных студенческих[7] олимпиад по математике канадско-украинского происхождения была стажёром-разработчиком в Google в 2013 и 2015 годах, а позже выступила сооснователем Future of Life Institute[8] в Бостоне — одной из ведущих научно-исследовательских организаций в мире, которая занимается вопросами безопасности искусственного разума.

Ян Лейке тоже изучает безопасность ИИ. Он числится научным сотрудником института Future of Humanity Institute, а летом этого года удостоился награды за лучшую студенческую работу на конференции «Неопределённость в Искусственном интеллекте». Работа посвящена применению метода Томпсона в самообучении нейронных сетей с подкреплением (текст научной работы).

Педро Ортега — кандидат наук (PhD) в области машинного обучения Кембриджского университета.

О потенциальной опасности сверхразумного Искусственного интеллекта предупреждали многие учёные. Например, британский физик и математик Стивен Хокинг сказал[13], что недооценка угрозы со стороны искусственного интеллекта может стать самой большой ошибкой в истории человечества, если мы не научимся избегать рисков.

Стивен Хокинг с соавторами статьи[14] предупреждает об опасности, если машины с нечеловеческим интеллектом самосовершенствоваться и ничто не сможет остановить данный процесс. Это, в свою очередь, запустит процесс так называемой технологической сингулярности.

Такая технология превзойдет человека и начнет управлять финансовыми рынками, научными исследованиями, людьми и разработкой оружия, недоступного нашему пониманию. Если краткосрочный эффект искусственного интеллекта зависит от того, кто им управляет, то долгосрочный эффект — от того, можно ли будет им управлять вообще.

Вероятно, компания DeepMind прислушалась к словам профессора — и предпринимает необходимые меры безопасности. Хокинг с соавторами статьи упоминали, что вопросам защиты от сильного ИИ посвящено мало серьёзных исследований за пределами таких некоммерческих организаций, как Кембриджский центр по изучению экзистенциальных рисков, Институт будущего человечества, а также научно-исследовательские институты машинного интеллекта и жизни будущего. На самом деле этим вопросам следует уделять гораздо больше внимания.

О потенциальной опасности ИИ предупреждал также Илон Маск. Год назад он с единомышленниками объявил[15] об основании некоммерческой организации OpenAI, которая рассматривает открытые исследования Сильного ИИ как способ хеджирования рисков человечества против единого централизованного искусственного интеллекта.

В официальном объявлении об основании организации сказано: «В связи с непредсказуемой историей ИИ, сложно предугадать, когда может появиться ИИ человеческого уровня. Когда это произойдёт, важно будет иметь в распоряжении человечества ведущий исследовательский институт, который способен поставить приоритетом выигрыш для всех над своими собственными интересами».

Сейчас разработки в области сильного ИИ ведут научно-исследовательские организации и крупные коммерческие корпорации, такие как Google, Facebook и Microsoft.

Использованны источники

- ^ сильного (ru.wikipedia.org)

- ^ приступила к набору сотрудников (www.businessinsider.com)

- ^ Виктория Краковна (www.linkedin.com)

- ^ Ян Лейке (jan.leike.name)

- ^ Педро Ортега (www.adaptiveagents.org)

- ^ международных школьных (www.imo-official.org)

- ^ континентальных студенческих (www.maa.org)

- ^ Future of Life Institute (futureoflife.org)

- ^ Future of Humanity Institute (www.fhi.ox.ac.uk)

- ^ удостоился награды (www.fhi.ox.ac.uk)

- ^ метода Томпсона (en.wikipedia.org)

- ^ текст научной работы (auai.org)

- ^ сказал (geektimes.ru)

- ^ статьи (www.independent.co.uk)

- ^ объявил (geektimes.ru)